2026 年発表論文概要

IEEE International Conference on Robotics and Automation, ICRA 2026

Unsupervised Domain Adaptation for Robust Imitation Learning under Visual Perturbations

Yasuhiro Kato, Thomas Westfechtel, Jen-Yen Chang, Naoki Morihira, Akinobu Hayashi, Tatsuya Harada, Takayuki Osa

視覚情報に基づくロボットマニピュレーションシステムは、視覚入力におけるドメインシフトの影響により、しばしば性能劣化に直面する。データ拡張は強化学習において広く用いられているが、模倣学習への適用に関しては比較的十分な研究がなされていない。我々の予備実験は、単に拡張技術を導入するだけでは模倣学習において効果的な改善が得られないことを示している。この課題に対処するため、本研究では二段階の学習プロセスを提案する。第一段階では、データ拡張を活用した敵対的特徴学習フレームワークを構築し、ドメインシフトに対する頑健性を向上させる。第二段階では、容易に収集可能な画像データのみを用いて目標環境にモデルを適応させる教師なしドメイン適応手法を導入する。ロボットタスクにおいては、視覚的ドメインシフトは初期観測のみから検出可能であることが多い。新規ドメインにおいて行動ラベル付きの完全なエピソードを収集することは高コストであるため、初期画像のみを用いた適応はデータ収集コストを大幅に削減する。この目的のため、本研究では目標ドメインの初期観測のみに依存し、ラベル付きデモンストレーションを必要としない適応戦略を開発する。シミュレーションおよび実機ロボット実装の双方における実験結果は、提案手法がソースドメインの性能を保持しつつ、照明条件の変動、背景の変更、環境的妨害要因を含む視覚的摂動に対して強化された耐性を示すことを実証している。

視覚情報に基づくロボットマニピュレーションシステムは、視覚入力におけるドメインシフトの影響により、しばしば性能劣化に直面する。データ拡張は強化学習において広く用いられているが、模倣学習への適用に関しては比較的十分な研究がなされていない。我々の予備実験は、単に拡張技術を導入するだけでは模倣学習において効果的な改善が得られないことを示している。この課題に対処するため、本研究では二段階の学習プロセスを提案する。第一段階では、データ拡張を活用した敵対的特徴学習フレームワークを構築し、ドメインシフトに対する頑健性を向上させる。第二段階では、容易に収集可能な画像データのみを用いて目標環境にモデルを適応させる教師なしドメイン適応手法を導入する。ロボットタスクにおいては、視覚的ドメインシフトは初期観測のみから検出可能であることが多い。新規ドメインにおいて行動ラベル付きの完全なエピソードを収集することは高コストであるため、初期画像のみを用いた適応はデータ収集コストを大幅に削減する。この目的のため、本研究では目標ドメインの初期観測のみに依存し、ラベル付きデモンストレーションを必要としない適応戦略を開発する。シミュレーションおよび実機ロボット実装の双方における実験結果は、提案手法がソースドメインの性能を保持しつつ、照明条件の変動、背景の変更、環境的妨害要因を含む視覚的摂動に対して強化された耐性を示すことを実証している。

The Fourteenth International Conference on Learning Representations, ICLR 2026

R2-Dreamer: Redundancy-Reduced World Models without Decoders or Augmentation

Naoki Morihira, Amal Nahar, Kartik Bharadwaj, Kato Yasuhiro, Akinobu Hayashi, Tatsuya Harada

画像ベースのモデルベース強化学習(MBRL)における主要な課題の一つは、不要な視覚的詳細からタスクに不可欠な情報を抽出した表現を学習することにある。再構成ベースの手法は有望ではあるが、背景などタスクに関係のない広範な領域にリソースを浪費してしまうことが多い。対して、デコーダーを用いない手法はデータ拡張を活用することで頑健な表現を学習するが、表現の崩壊を防ぐためにこうした外部の正則化に依存することが汎用性を制限していた。本研究では、データ拡張に頼ることなく崩壊を防ぐ内部正則化として機能する自己教師あり学習の目的関数を備えた、デコーダーレスMBRLフレームワーク「R2-Dreamer」を提案する。本手法の核心はBarlow Twinsに着想を得た特徴の冗長性削減にあり、既存のフレームワークへ容易に統合が可能である。DeepMind Control SuiteおよびMeta-Worldを用いた実験において、R2-DreamerはDreamerV3やTD-MPC2といった強力なベースラインに匹敵する性能を示しつつ、DreamerV3比で1.59倍高速な学習を実現した。さらに、タスクに関連するオブジェクトが極めて小さいDMC-Subtleにおいては、大幅な性能向上を達成した。これらの結果は、効果的な内部正則化が、汎用性が高く高性能なデコーダーレスMBRLを可能にすることを示唆している。

画像ベースのモデルベース強化学習(MBRL)における主要な課題の一つは、不要な視覚的詳細からタスクに不可欠な情報を抽出した表現を学習することにある。再構成ベースの手法は有望ではあるが、背景などタスクに関係のない広範な領域にリソースを浪費してしまうことが多い。対して、デコーダーを用いない手法はデータ拡張を活用することで頑健な表現を学習するが、表現の崩壊を防ぐためにこうした外部の正則化に依存することが汎用性を制限していた。本研究では、データ拡張に頼ることなく崩壊を防ぐ内部正則化として機能する自己教師あり学習の目的関数を備えた、デコーダーレスMBRLフレームワーク「R2-Dreamer」を提案する。本手法の核心はBarlow Twinsに着想を得た特徴の冗長性削減にあり、既存のフレームワークへ容易に統合が可能である。DeepMind Control SuiteおよびMeta-Worldを用いた実験において、R2-DreamerはDreamerV3やTD-MPC2といった強力なベースラインに匹敵する性能を示しつつ、DreamerV3比で1.59倍高速な学習を実現した。さらに、タスクに関連するオブジェクトが極めて小さいDMC-Subtleにおいては、大幅な性能向上を達成した。これらの結果は、効果的な内部正則化が、汎用性が高く高性能なデコーダーレスMBRLを可能にすることを示唆している。

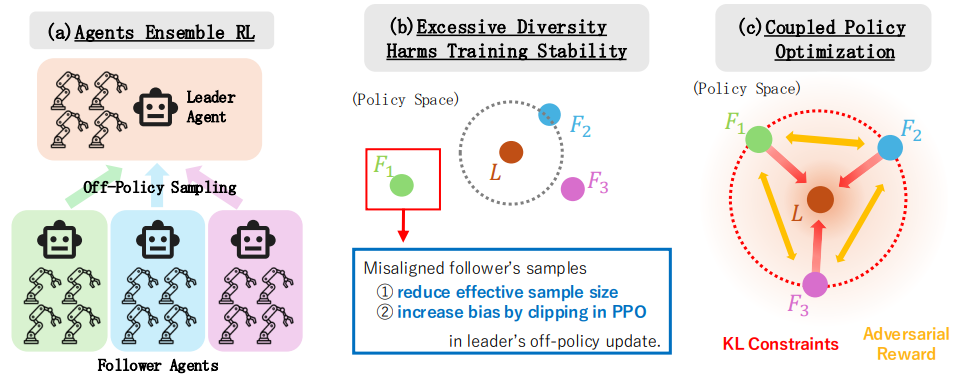

Rethinking Policy Diversity in Ensemble Policy Gradient in Large-Scale Reinforcement Learning

Naoki Shitanda, Motoki Omura, Tatsuya Harada, Takayuki Osa

数万規模の並列環境に強化学習をスケールさせるには、単一方策が持つ探索能力の限界を克服する必要がある。そこで近年、複数の方策を用いて多様なサンプルを収集するアンサンブル型方策勾配法は、探索を促進する手法として提案されてきた。しかし、過度な探索は探索の質を低下させたり、学習の安定性を損なったりする可能性があるため、探索空間を単に広げるだけでは必ずしも学習能力の向上につながらない。本研究では、方策アンサンブルにおける方策間の多様性が学習効率に与える影響を理論的に解析し、方策間の KL 制約によって多様性を制御する Coupled Policy Optimization(CPO)を提案する。提案手法は効果的な探索を可能にし、複数のデクスタラスマニピュレーションタスクにおいて、サンプル効率および最終性能の両面で SAPG、PBT、PPO といった強力なベースラインを上回る性能を示した。さらに、学習中の方策多様性および有効サンプルサイズの解析から、フォロワー方策がリーダー方策の周囲に自然に分布することが明らかになり、構造化された効率的な探索行動が自発的に創発していることが示された。これらの結果は、適切に制御された多様な探索こそが、アンサンブル型方策勾配法において安定かつサンプル効率の高い学習を達成する鍵であることを示している。

数万規模の並列環境に強化学習をスケールさせるには、単一方策が持つ探索能力の限界を克服する必要がある。そこで近年、複数の方策を用いて多様なサンプルを収集するアンサンブル型方策勾配法は、探索を促進する手法として提案されてきた。しかし、過度な探索は探索の質を低下させたり、学習の安定性を損なったりする可能性があるため、探索空間を単に広げるだけでは必ずしも学習能力の向上につながらない。本研究では、方策アンサンブルにおける方策間の多様性が学習効率に与える影響を理論的に解析し、方策間の KL 制約によって多様性を制御する Coupled Policy Optimization(CPO)を提案する。提案手法は効果的な探索を可能にし、複数のデクスタラスマニピュレーションタスクにおいて、サンプル効率および最終性能の両面で SAPG、PBT、PPO といった強力なベースラインを上回る性能を示した。さらに、学習中の方策多様性および有効サンプルサイズの解析から、フォロワー方策がリーダー方策の周囲に自然に分布することが明らかになり、構造化された効率的な探索行動が自発的に創発していることが示された。これらの結果は、適切に制御された多様な探索こそが、アンサンブル型方策勾配法において安定かつサンプル効率の高い学習を達成する鍵であることを示している。

Cross-Embodiment Offline Reinforcement Learning for Heterogeneous Robot Datasets

Haruki Abe, Takayuki Osa, Yusuke Mukuta, Tatsuya Harada

スケーラブルなロボット方策の事前学習は、各プラットフォームごとに高品質なデモンストレーションを収集するコストが高いことによって阻害されてきた。本研究では、オフライン強化学習とクロスエンボディメント学習を統合することで、この問題に対処する。オフライン強化学習は、専門家データに加えて大量のサブオプティマル(最適ではない)データも活用できる。一方、クロスエンボディメント学習は、多様な形態を持つロボットから得られる多様なの軌跡を集約し、普遍的なロボット制御の事前知識を獲得する。私たちは、このオフライン強化学習とクロスエンボディメントの枠組みを体系的に分析し、その強みと限界を原理的に理解できるようにした。この枠組みを評価するため、16種類の異なるロボットプラットフォームにまたがるロコモーションデータセット群を構築した。実験により、この統合アプローチはサブオプティマルな軌跡を豊富に含むデータセットでの事前学習において特に有効であり、純粋なbehavior cloningを上回ることを確認した。しかし、サブオプティマルデータの割合やロボット種類数が増えるにつれて、形態の違いに起因する勾配の衝突が学習を阻害し始めることも観測された。これを緩和するため、ロボットを形態的な類似性に基づいてクラスタリングし、各グループの勾配でモデルを更新する「エンボディメントに基づくグルーピング戦略」を導入する。この単純で静的なグルーピングにより、ロボット間の衝突が大幅に減少し、既存の衝突解決手法よりも優れた性能を示した。

スケーラブルなロボット方策の事前学習は、各プラットフォームごとに高品質なデモンストレーションを収集するコストが高いことによって阻害されてきた。本研究では、オフライン強化学習とクロスエンボディメント学習を統合することで、この問題に対処する。オフライン強化学習は、専門家データに加えて大量のサブオプティマル(最適ではない)データも活用できる。一方、クロスエンボディメント学習は、多様な形態を持つロボットから得られる多様なの軌跡を集約し、普遍的なロボット制御の事前知識を獲得する。私たちは、このオフライン強化学習とクロスエンボディメントの枠組みを体系的に分析し、その強みと限界を原理的に理解できるようにした。この枠組みを評価するため、16種類の異なるロボットプラットフォームにまたがるロコモーションデータセット群を構築した。実験により、この統合アプローチはサブオプティマルな軌跡を豊富に含むデータセットでの事前学習において特に有効であり、純粋なbehavior cloningを上回ることを確認した。しかし、サブオプティマルデータの割合やロボット種類数が増えるにつれて、形態の違いに起因する勾配の衝突が学習を阻害し始めることも観測された。これを緩和するため、ロボットを形態的な類似性に基づいてクラスタリングし、各グループの勾配でモデルを更新する「エンボディメントに基づくグルーピング戦略」を導入する。この単純で静的なグルーピングにより、ロボット間の衝突が大幅に減少し、既存の衝突解決手法よりも優れた性能を示した。