VQA

VQAとは

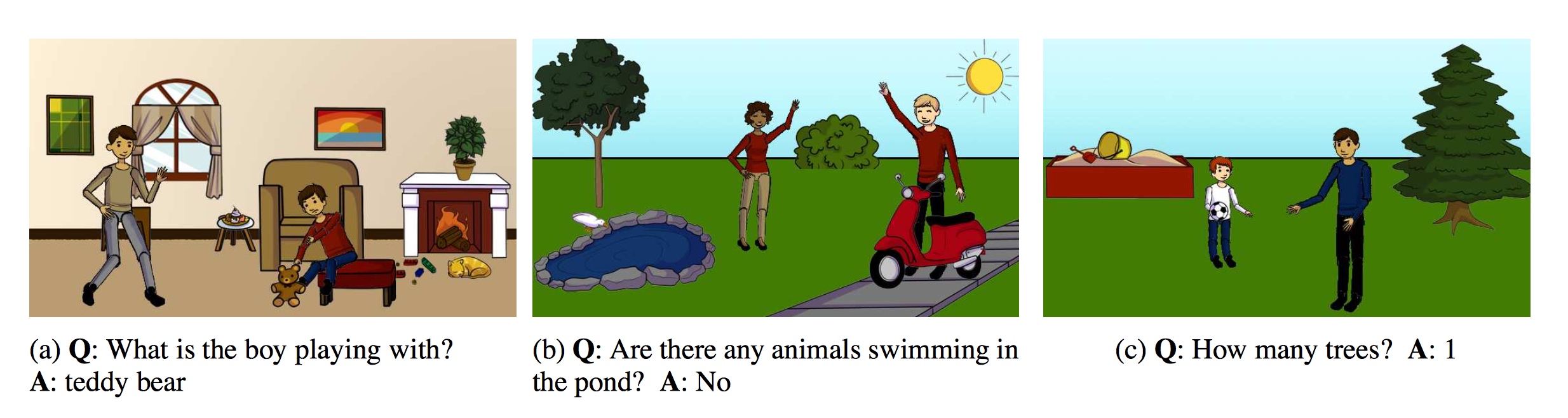

Visual Question Answering(VQA)とは,ある画像とその画像に関する質問を提示されたときに,正しい答えを導き出すタスクです. このというタスクが広く知られるようになったきっかけとして,2016年のCVPRでコンペティションが行われたことが挙げられます. このコンペティションは,数十万セットの質問文と画像と答えのセットから正しい答えを導きだすモデルを学習させ,その精度を競うというものでした. YES/NOで答えられるものから,物体に何が映っているかを示すもの,数を答えなければいけないものまで,質問文の種類は様々なものが用意されています.

画像と画像に対する質問文の例(参考文献1から引用)

なお,このコンペでは,自然画像に対する質問文のものと,アブストラクト画像(クリップアートの組み合わせ)に対する質問文のものとが用意されていました.

さて,画像や音,言語などのことを,それぞれ「モダリティ」と呼びます.VQAは,画像と言語という二つのモダリティを扱ったタスクということができます. このような,ひとつのモダリティではなく複数のモダリティを対象とする「マルチモーダル」な研究というのは,これまでも行われてきました. 例えば,画像に説明文を与える研究などは,弊研究室でもいろいろな取り組みがなされています. マルチモーダルな研究の中でも,VQAは,ヒトとAIがコミュニケーションを取る上で大きな一歩になると期待されています.

関連研究

一番関連が深いと思われるのは,画像に対して説明文を生成する「Image Captioning」と呼ばれるタスクです. これは,先にも挙げたように,モダリティを変換するタスクに当たります. 詳細は画像説明文生成のページを参照していただければと思いますが,このタスクでは「画像の中の情報をうまく理解すること」「言語の情報を理解すること」という,二つの情報の取扱が要求されます. これはVQAでも同じなので,関連が深いと言えます.

この研究室の独自性と成果

VQAに関する多くの研究では,アテンション(attention,注意)の取扱を組み込んだモデルが用いられています. このようなモデルというのは,質問文と画像が投げかけられたときに,「質問文に応じて画像のどこに注目すれば適切な答えが得られるのか」というものを考えるモデルです. これまで,多くの精度の高いモデルはそういった枠組みを使っていました. しかし,アブストラクト画像は,実画像と異なる特徴を持つので,実画像と同じようにアテンションの手法を適用しても精度が見込めないという問題点があります. そこで,我々はアテンションを使うのではなく,画像の情報と文章の情報をどう混ぜ合わせるのかに注目して研究を行いました. VQAにおいては,質問文の内容に基づいて画像中のどういう情報を持ってくればいいのかがだいたい決まってくるので,具体的に画像中のどこに注目するのかを考えるのではなく,どのように混ぜ合わせるのかを考えよう,というアプローチです. 結果としては,我々が今回提案した手法は実画像でも,そして従来手法が苦手としていたアブストラクト画像のどちらでも,適用可能になりました. 冒頭に挙げたコンペティションでは,実画像部門では世界8位となりました.アブストラクト画像では,よりアブストラクト画像に特化した別の手法で世界1位となっていますが,実画像に適用した手法でも世界1位(当時)相当の精度が出ることを確認しています.

アブストラクト画像に対する質問文と生成された回答の例(参考文献2から引用)

今後の方向性

今回はアブストラクト画像と実画像の部門では別々にスコアを出しました.しかし本来は,画像のドメインが違ったとしても,モデルが何らかの普遍的な知識を有していれば,どちらの質問にも答えられるはずと考えられます. そのため,ドメインに対して不変な手法の提案が求められています.

参考文献

- Stanislaw Antol, Aishwarya Agrawal, Jiasen Lu, Margaret Mitchell, Dhruv Batra, C. Lawrence Zitnick, Devi Parikh, "VQA: Visual Question Answering", International Conference on Computer Vision (ICCV 2015), 2015

- Kuniaki Saito, Andrew Shin, Yoshitaka Ushiku, Tatsuya Harada, "DUALNET: DOMAIN-INVARIANT NETWORK FOR VISUAL QUESTION ANSWERING", The 18th IEEE International Conference on Multimedia and Expo (ICME 2017), 2017